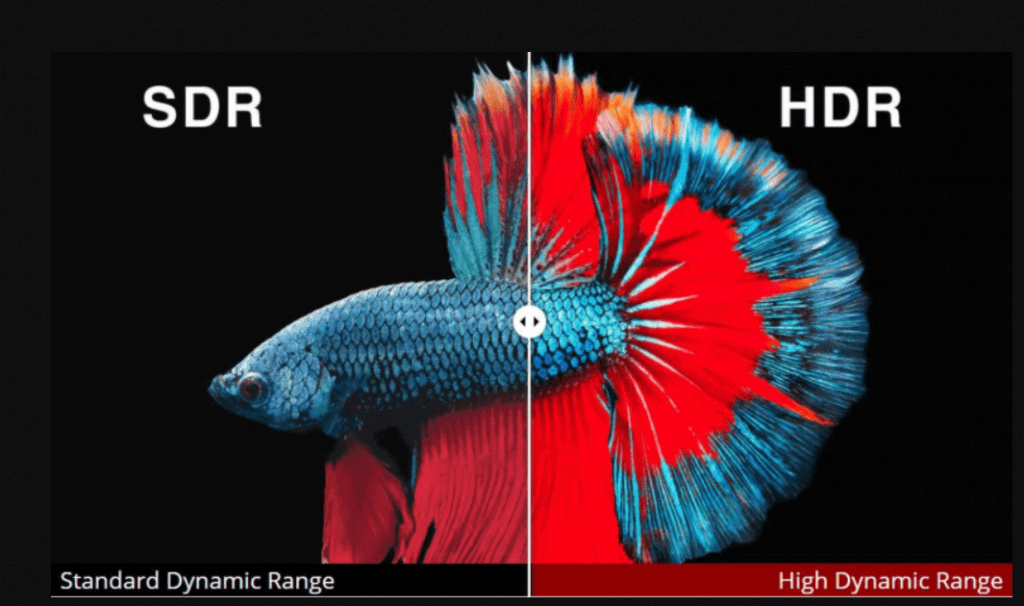

HDR o High Dynamic Range consiste en una técnica que va a mejorar la calidad de nuestra imagen a través de un mayor rango dinámico, es decir, aumentado cuan clara y oscura nuestra pantalla puede llegar a ser. Por lo que vamos a tener tonos oscuros más oscuros y tonos claros o brillantes mucho más brillantes.

Pero antes de seguir, tienes que entender qué es el contraste y rango dinámico en una TV.

Puedes abrir este enlace y ver la comparativa anterior a mejor calidad

Contraste & Rango Dinámico

Si queremos saber si una TV es de mayor o menor gama, una de las características más importantes es el contraste.

El contraste es la diferencia entre el blanco más brillante y el negro más oscuro que puede mostrar nuestra pantalla.

Generalmente se indica en un factor como este 3000:1, esto significa que el blanco más blanco es 3000 veces más brillante que el negro más oscuro, cuanto mayor es este valor mejor ya que un mayor contraste resulta en colores más vivos y más precisos.

El rango dinámico consiste en ajustar el brillo a tiempo real (de ahí que sea dinámico), el contenido HDR tiene metadata (datos que dan información para definir otros datos) que indican para cada frame el nivel de brillo y por tanto, de manera indirecta de contraste, esto permite que la calidad general sea más elevada ya que a diferencia de mantener un brillo varía según la escena.

Muchas de las TV 4K actuales disponen de al menos HDR10 y por esta razón también mucho del contenido producido también soporta HDR o Dolby Vision, más adelante hablaremos de los diferentes tipos de HDR.

La creciente tendencia hacia esta tecnología ha causado que las principales plataformas de streaming comiencen a dar soporte, por ejemplo en Prime Video podemos ver antes de ver una película o serie si está soporta HDR, si no lo indica significa que no lo soporta.

Gama de colores

Un concepto muy relacionado con HDR es el de WCG (Wide Color Gamut), que significa Amplia Gama de Color.

Esta relación se da porque para que HDR pueda mostrar mejores colores y más vivos, también es casi imprescindible tener una más ampia gama de colores, por lo que en el 90% de casos, una TV con HDR también va a ser WGC.

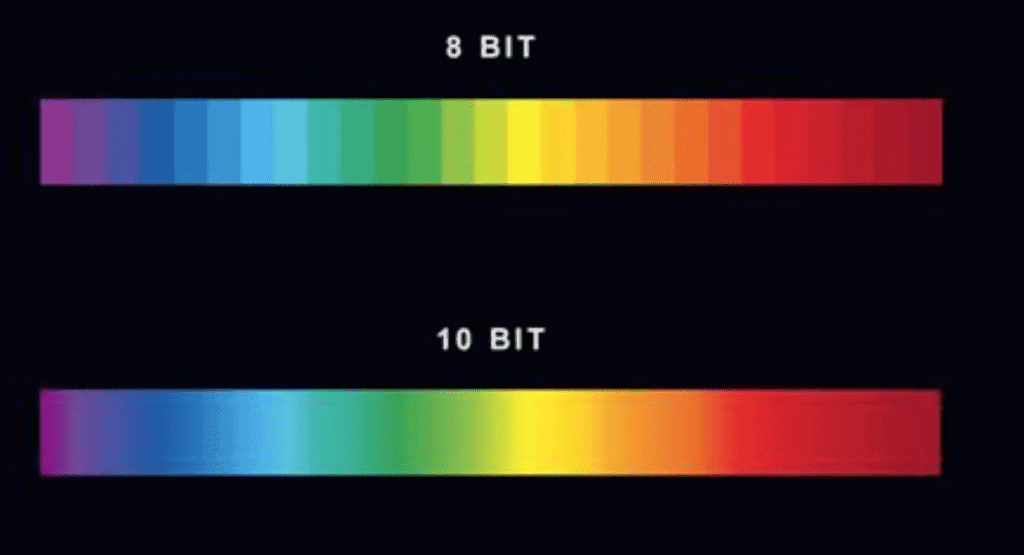

Una pantalla capaz de WGC o (Wide Color Gamut) va a tener un panel de 10 bit frente al habitual de 8 bits, esta característica se conoce como Bit Depth (Profundidad de bits) para ver esto con números un panel de 8 bits puede mostrar un total de 16.777.216 colores versus los 1.073.741.824 colores de uno de 10 bit. Estamos hablando de un salto de los 16 millones al billón de colores.

Existen también paneles de 12 y 16 bits, pero estos son muy díficiles de encontrar y poco contenido puede aprovechar los 12/16 bits.

Brillo – Un punto decisivo

Otro punto que no podemos olvidar cuando hablamos sobre HDR es el brillo, como hemos mencionado al inicio, HDR permite obtener una mejor calidad de imagen gracias a aumentar su rango de tonos oscuros, brillantes o blancos y ofrecer colores más vivos, pero para que esto pueda suceder también vamos a necesitar tener un mínimo de brillo.

Una gran cantidad de las TV baratas del mercado ofrecen cifras entre los 300 y 400 cd/m², un número inferior a los 600 cd/m² recomendados para comenzar a tener una experiencia HDR adecuada, y desde luego muy lejanos de los 1000 cd/m² ansiados por tantos para disfrutar ahora sí, de una calidad de imagen deslumbrante.

Pero claro, como siempre esto recae en el bolsillo del consumidor, televisiones de más alta gama tienen más brillo mientras que la gama baja se mantiene sobre las cifras mencionadas de 300 cd/m².

Tipos de HDR

HDR10

Este es el tipo más básico de HDR, es un estándar abierto por lo que cualquier compañía puede obtener esta certificación de manera gratuita.

HDR10 no es de tipo dinámico a pesar de ser HDR, sino que es estático por lo que cuando vamos a ver una película se envia metadata que va a indicar los valores fijados de brillo y contraste para el contenido a reproducir.

Este tipo de HDR no es retrocompatible con SDR. Soporta hasta un máximo de 1000 cd/m² y 10 bit de color.

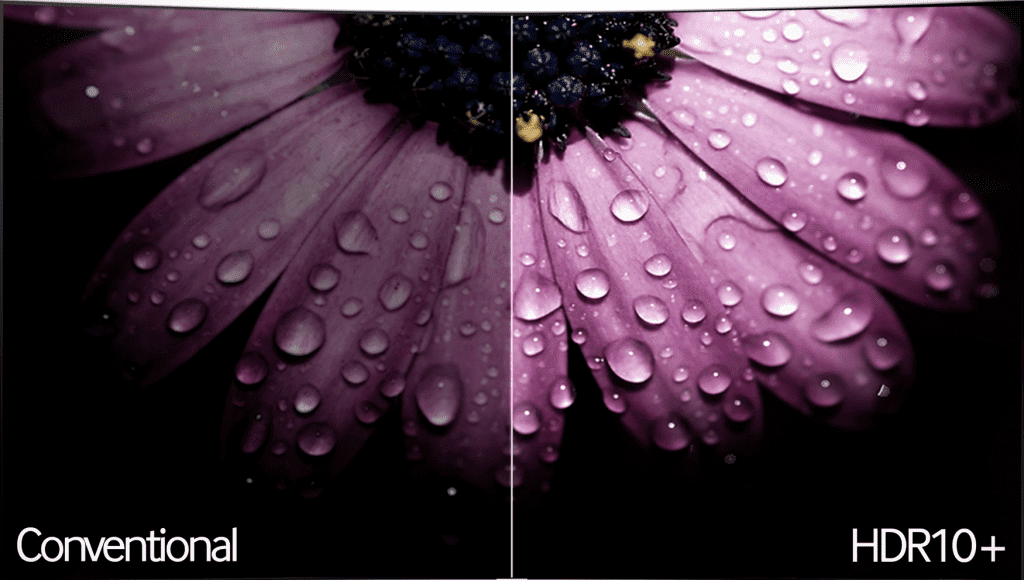

HDR10+

Nos encontramos ante una versión mejorada de HDR10, esta variante fue diseñada por Samsung tomando como base HDR10 con el objetivo de vencer o al menos igualar a Dolby Vision mientras se mantenía como un estándar abierto.

Si hablamos de HDR10+ debemos mencionar el máximo teórico de 4000 cd/m² de brillo, manteniendo los 10 bits de color máximos.

Aunque esta versión de HDR no ha llegado a igualar a Dolby Vision al menos ofrece una mejora sobre su hermano menor, además se encuentra presente en todas las televisiones UHD (4K) de Samsung desde 2017. Sin embargo, no es tan usado como HDR10 o Dolby Vision y no todas plataformas de streaming (Netflix, Prime Video, Disney…) lo soportan a día de hoy.

Dolby Vision

Dolby Vision es propiedad de Dolby, por lo que si una empresa quiere que su televisión o monitor esté certificado como compatible han de pagar una tasa, además de tener unos requisitos mínimos.

Dolby Vision emplea metadata de manera dinámica y tiene un máximo teórico de 10,000 cd/m² frente a los 1000 cd/m² de HDR10 y los 4000 cd/m² de HDR10+.

En cuanto a la profundidad de color, mientras HDR/HDR10+ se topan con el límite en los 10 bits, Dolby Vision permite hasta 12 bits de profundidad.

Este tipo de HDR todavía no es un gran avance frente a los demás, ya que la mayoría del contenido que se produce de alta calidad es a 10 bits de color y las pantallas están lejos del apabullante límite de 4000 cd/m² de HDR10+.

HLG (Hybrid Log Gamma)

HLG o Hybrid Log Gamma es la versión de HDR más diferente, viene a solucionar el problema de que el contenido HDR no sea retrocompatible con pantallas SDR, razón por la que al ver contenido HDR en una pantalla que no lo soporta los colores se ven poco vivos. Es ahí donde entra HLG que SÍ que es compatible con pantallas SDR evitando así que el contenido se vea peor.

Este tipo de HDR no requiere de metadata, esto además aumenta en gran medida su compatibilidad ya que evita que la pantalla sea capaz de interpretar la metadata que recibe.

HLG permite codificar la información tanto de HDR como de SDR en una sola señal, esto se traduce en un gran ahorro de bandwitdh (ancho de banda). Por esta razón se emplea principalmente en broadcasting, directos y para la televisión satelital.

Estos tres sectores mencionados son casi exclusivamente los únicos donde se emplea este tipo de HDR, ya que la mayoría de productores deciden ir a por un estándar HDR como HDR10 o Dolby Vision y no HLG a la hora de grabar contenido.

Esta tecnología HDR – HLG fue diseñada por la BBC y y Japan’s NHK cuando ambos buscaban una solución para el problema del ancho de banda para contenido televisivo y directos.

¿Quién es el ganador?

No podríamos definir un claro ganador, aunque podemos decir que Dolby Vision es una opción más segura gracias a su máximo teórico de 10,000 cd/m² y los 12 bits de color, por esto si podemos obtener una pantalla con Dolby Vision es una mejor apuesta a nivel de futuro.

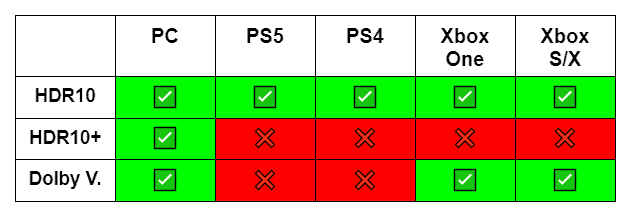

Lo que sí que podemos comparar directamente es la compatibilidad de los diferentes tipos de HDR en sectores como el gaming.

Deja una respuesta