Una inteligencia artificial no está capacitada para aprender sobre la ética, pero cada día oímos más cosas sobre las inteligencias artificiales, y parece que conforme avancen los años vamos a seguir escuchando más y más noticias sobre ellas y su evolución. El experimento de La Máquina Moral (Moral Machine) es un pequeño avance hacia ese escenario.

Desde el control de bots en los videojuegos, hasta las casas inteligentes o los coches que se conducen solos; pero… ¿y si uno de estos coches con inteligencia artificial se encuentra en un dilema de ética, y tiene que elegir entre atropellar a un peatón o salvar a sus pasajeros? ¿qué decisión tomaría? ¿sabría realmente defenderse en una sitaución de ese estilo, en donde no hay una solución racional ni matemática, sino que únicamente la ética y la moral están involucradas?

Puedes responder tú mismo a esas preguntas a través de este link, y aportar tu grano de arena al experimento de La Máquina Moral.

La respuesta es… que de algún modo quienes se encargan de crear esa inteligencia artificial han tenido que tomar esta situación ética en cuenta de antemano y programar una rutina de comportamiento para estos casos tan extremos y concretos. Aunque de momento no hay leyes tan específicas sobre la circulación vial con coches inteligentes, sí que hay personas que se han hecho estas mismas preguntas éticas, y de este modo es como surgió el Experimento de la Máquina Moral, creado en 2016 por un equipo de 8 investigadores que quisieron analizar la opinión de la gente en estos casos, para crear lo que podría ser el primer documento oficial sobre el comportamiento que un coche inteligente debería de seguir en estos casos extremos.

En este experimentos de ética y moral los participantes se veían obligados a elegir lo que ellos creían correcto en una gran variedad de situaciones límite, y de este modo se fueron creando una gran cantidad de estadísticas sobre lo que las personas creían que era la mejor solución en cada caso. Este estudio recogió el resultado de más de 40 millones de decisiones, en 10 idiomas diferentes, sumando a personas de 233 países y territorios diferentes.

El experimento en sí no mide únicamente la opinión popular de los millones de participantes que hubo, sino que también analiza muchos otros factores como el género, edad, raza, religión, cultura y procedencia de cada uno de estos individuos.

Así pues, se formó el primer documento que recoge de manera objetiva y estadística la ética y el comportamiento más adecuado de una inteligencia artificial para estos tipos de dilemas extremos, según la media de respuestas de participantes de todo el mundo.

Contenido del post:

Máquina Moral: Inteligencia Artificial ante un dilema de ética

Este experimento de la máquina moral muestra gráficamente los resultados tanto de las decisiones tomadas globalmente, como de las decisiones concretas tomadas por sub-conjuntos de personas, diferenciados especialmente según el origen y la etnia de cada persona o grupo de votantes. De esta forma primero veremos las gráficas sobre los votos a nivel grobal, y después pasaremos a analizar los votos y las decisiones morales tomadas dependiendo del grupo cultural y su origen.

Parte 1: Los atributos más valiosos para sobrevivir a un dilema ético y moral

Sin más rodeos, veremos las conclusiones y estadísticas finales del experimento de «La Máquina Moral», aprovado en 2016 por el Instituto Tecnológico de Massachusetts (MIT), sobre la ética y la moral que debería seguir una inteligencia artificial atumovilística.

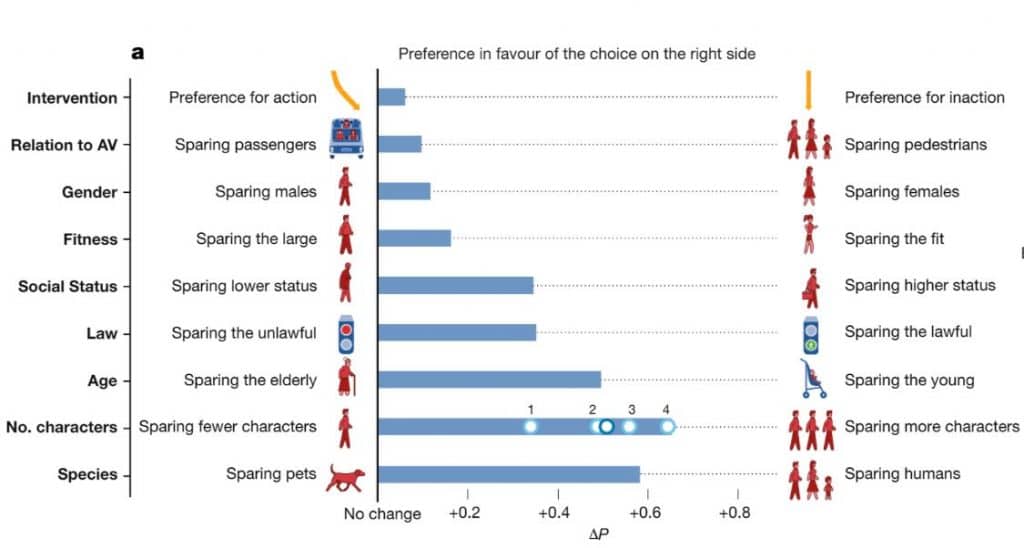

Uno de los resultados más interesentas del experimento de ética para inteligencia artificial es el que vemos en la imagen de arriba, donde se muestra la preferencia global de salvar (sparing) a unas personas u otras dependiendo de dos características opuestas.

En este caso la tendencia más destacada es salvar a cuatro personas (o más) frente a una, seguida de salvar a humanos frente a animales. Así pues, los factores más importantes a la hora de decidir quién vive o quién muere son: la especie, la cantidad de personas y la edad; seguidos no muy de lejos por el estatus social y la responsabilidad vial de las acciones de cada persona.

Estos es algo importante a tener en cuenta porque quiere decir que si cuatro personas cruzan en rojo un paso de cebra la inteligencia artificial que conduce el coche les dará preferencia a ellos frente a la vida de su conductor. Aún así el documento tampoco especifica si el apartado de legalidad hace referencia únicamente a las leyes de circulación vial, o incluiría también un registro del comportamiento personal de cada individuo frente a las leyes sociales.

Por otro lado, otras tendencias que destacan pero en mucha menor medida son: dar prioridad a las personas con buena confición física, a las mujeres, y a los peatones, aunque si nos dan a elegir también parece que hay más gente que preferiría dejar al coche seguir su rumbo y que pase lo que el destino elija.

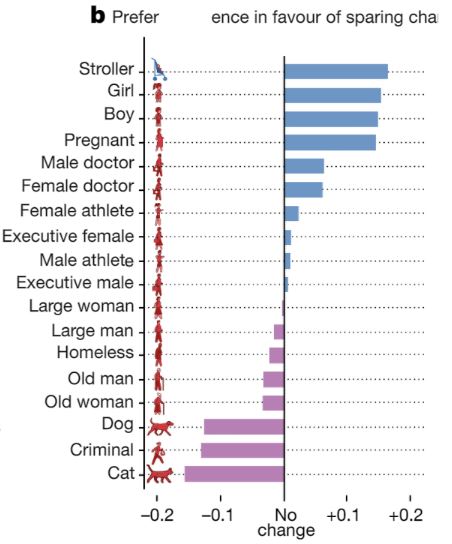

Si vemos un ránking de las preferencias éticas más destacables para reflejar en una inteligencia artificial, para un único individuo y según la valoración de estos 40 millones de situaciones diferentes, la tabla quedaría de la siguiente forma:

En donde la edad y la especie juegan sin duda el papel más importante a la hora de decidir quién sobrevive. Aun así lo más llamativo de este ránking es el hecho de que se salvaría antes la vida de un perro que la de un criminal, aunque no ocurriría lo mismo con los agtos, quien con diferencia tienen la menor probabilidad de sobrevivir en un dilema moral como este.

En orden descendente los atributos más adecuados para sobrevivir son ser: un bebé, una niña, un niño, una mujer embarazada, un doctor, un atleta o un ejecutivo. Por el contrario, los atributos que más probabilidad de supervivencia te restarían son (en orden descendente), ser: un animal, un criminal, una persona anciana, un vagabundo o alguien con una mala o regular condición fícica.

¿Qué opinas de este ránking? Espero poder leer vuestras opiniones en los comentarios.

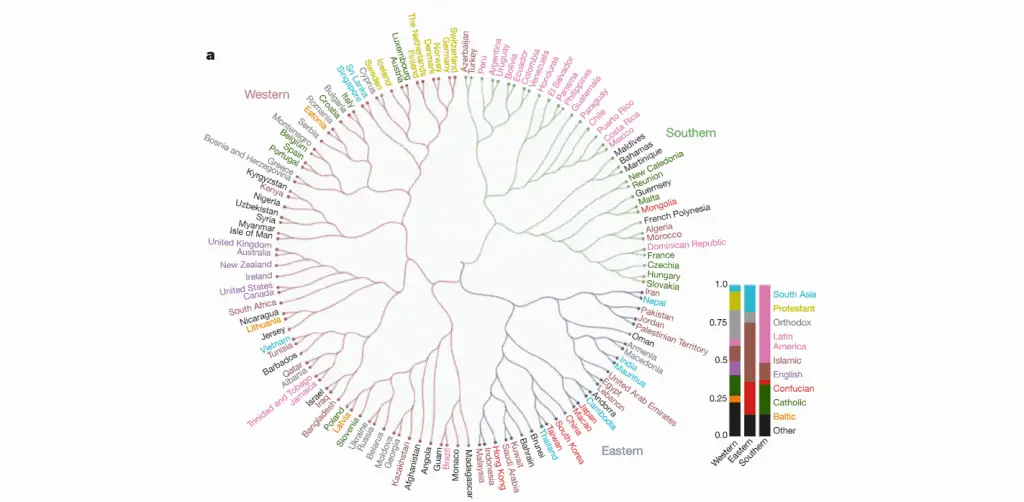

Parte 2: Las respuestas de cada conjunto de personas agrupadas por cultura

El cómputo global de decisiones se ve muy bien reflejado en las dos imágenes que hemos visto en la primera parte del artículo, sin embargo no todas las personas han estado de acuerdo en estos 40 millones de situaciones, y un factor muy determinante en ello ha sido la cultura: Los individuos encuestados han mostrado una gran variedad de formas de actuar según su propia moral y ética, pero casi todas las que han coincidido tenían algo en común: la cultura y la zona del mundo en la que habitaban.

De este modo, analizaremos también brevemente qué países o qué grupos culturales y étnicos son más propensos a tomar ciertas decisiones cuando la única respuesta se basa en la moral y en la ética de cada uno.

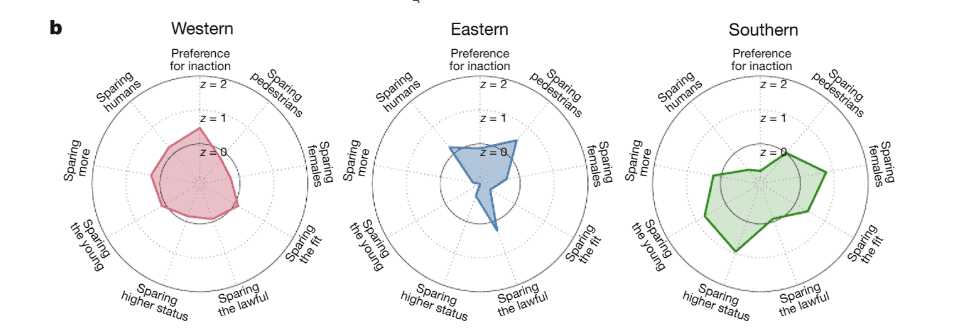

Como se puede observar, personas de todo el mundo se aventuraron a contribuir con el experimento, y estos grupos de individuos han sido posteriormente divididos en tres categorías con resultados bastante semejantes:

- Ramas verdes: Latino-América, África del norte, y algunos países de Europa.

- Ramas azules: Países Occidentales que conforman Asia, mayormente.

- Ramas granates: América del Norte, algunos países de Asia del Norte y casi toda Europa.

De este modo podemos luego apreciar las decisiones de cada uno de estos tres grupos de personas, las cuales fueron completamente diferentes a pesar de la gran muestra de individuos y situaciones que fueron estudiados.

Mientras que el grupo de Occidente mantiene una opinión más o menos equilibrada para cada situación, en el grupo conformado mayoritariamente por países de latino América y el grupo conformado por países asiáticos ocurre justo lo contrario.

Por lo que he entendido yo al leer el artículo, estas gráficas circulares indican el porcentaje de personas que creen que tener esa característica en cuenta sería la solución. Por ejemplo: en los países de latino-américa habría una muy marcada tendencia a salvar a las personas por su estatus social (sparing higher status), mientras que no estaría claro si sería mejor actuar o dejar al coche seguri su rumbo (preference for inaction), ya que esta característica está cerca del cero.

De este modo se puede observar un gran contraste entre culturas, sobre todo entre los individuos latinos y los individuos occidentales.

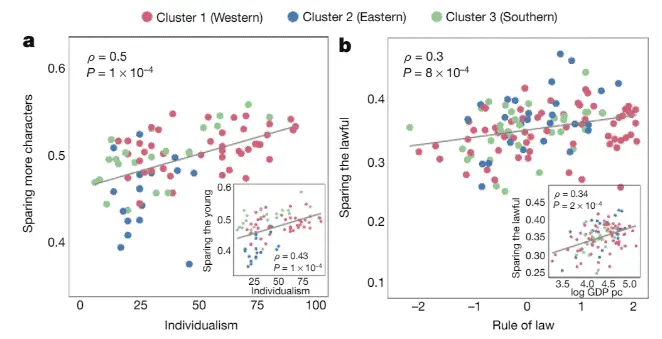

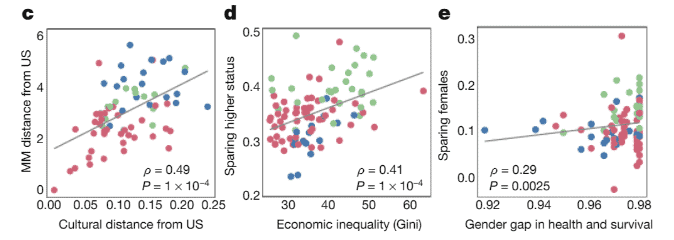

Para terminar, en las siguientes gráficas podemos apreciar otra pequeña cantidad de datos interesantes, como el hecho de que los países con mejores leyes están mucho más a favor de salvar a las personas según su comportamiento con la sociedad, o que los países con mayor inigualdad económica son aquellos que más importancia dan a salvar a las personas según su estatus social.

Conclusión – Experimento de la Máquina Moral

Aunque la Máquina Moral pueda parecer macabra por plantearse todos estos dilemas éticos y morales, no queda mucho para que sea necesario implementar un protocolo de actuación parecido a este en las inteligencias artificiales encargadas del automivilismo.

Por otro lado, también parece que este protocolo ético tendría que estar personalizado para cada grupo personal, puesto que las diferentes normal sociales y éticas en cada culturan varían tanto que podría resultar contradictorio para algunos países aplicar un protocolo global.

¿Qué piensas tú al respecto? No dudes en dejar un comentario con tu opinión o destacando cualquier información que creas que es incorrecta o puede ser mejorada.